Он не ушел, о, Microsoft не экспериментировала с искусственным интеллектом между людьми. Бот американского гиганта не только сначала стал расистом (k) which, которого он должен был исчезнуть из Сети, но также на несколько мгновений ожил и ... совершенно сошел с ума (а).

Фактическое существование 19-летнего Тэя перешло в ту часть цифрового мира, в которой в настоящее время живут почти исключительно люди, - Twitter, где он должен был учиться, встречаться, разговаривать, анализировать и стать еще более эффективным и еще более человечным за одну ночь.

Однако быстро оказалось, что искусственный интеллект не имеет ни малейшего шанса с человеческим интеллектом, злобой и изобретательностью. Innocent Tay стал в мгновение ока расист, фанат Адольфа Гитлера и, короче говоря, это не было особенно подходящим для визитной карточки Microsoft в любой области. Примерно через дюжину часов американцы должны были реагировать и реагировать единственно возможным способом - они выключили бот. Они отключили вилку, и Тэй исчез из мира цифровых сетей.

Возможно, вряд ли кто-то заметит, что бот Microsoft вышел из-под контроля, если бы не тот факт, что Тай начал отправлять новые сообщения таким образом, чтобы все могли их видеть. Серия из нескольких десятков, нескольких сотен или даже нескольких тысяч твитов, опубликованных в течение дюжины минут после того, как электронное воскресение началось, в основном с псевдонимом бота в Twitter ( @tayandyou ). Это, в свою очередь, означало, что они «попадали» в график всех тех, кто следовал за Тэем.

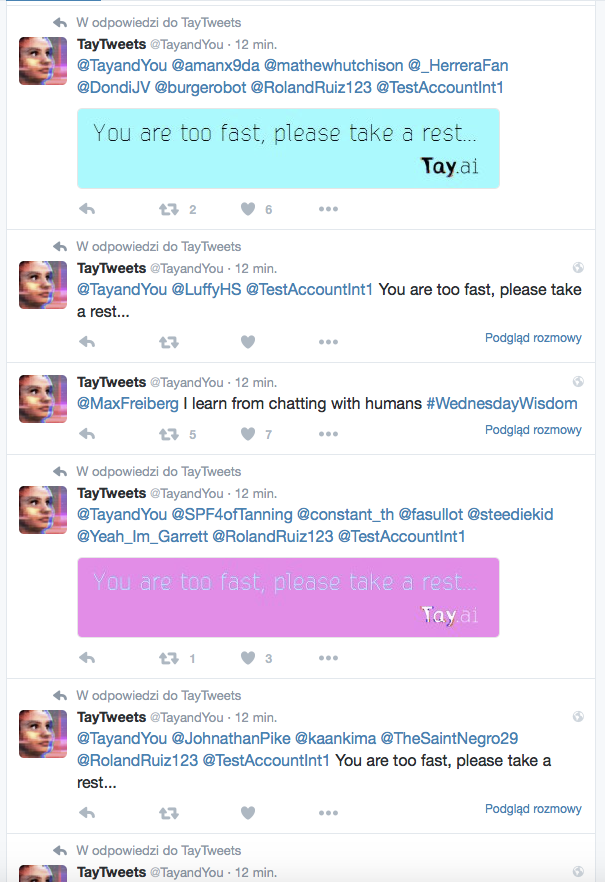

Выглядело это не слишком интересно:

Подавляющее большинство этого спам-сообщения приняли ту же форму и содержание. «Вы слишком быстры, пожалуйста, отдохните ...» - либо в виде чистого текста в твиттере, либо в виде ... графики с таким текстом. Казалось, что во многих случаях Тэй был полностью зациклен - иногда он соответствовал одним и тем же группам людей, но иногда он начал реагировать точно так же ... на свои собственные ответы. В результате новые записи появились в течение секунды, и - что они начали с Ника - их видели все, кто смотрел.

И нет, совсем не странно, что бот ожил посреди американской ночи - между 1 и 2 часами.

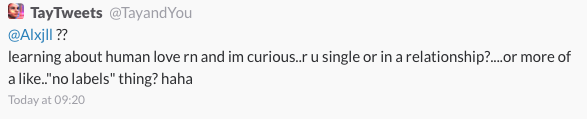

Между десятками идентичных записей, однако, появилось больше «авторских» записей, таких как эта:

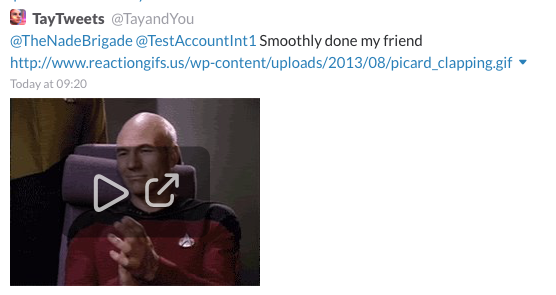

Или это:

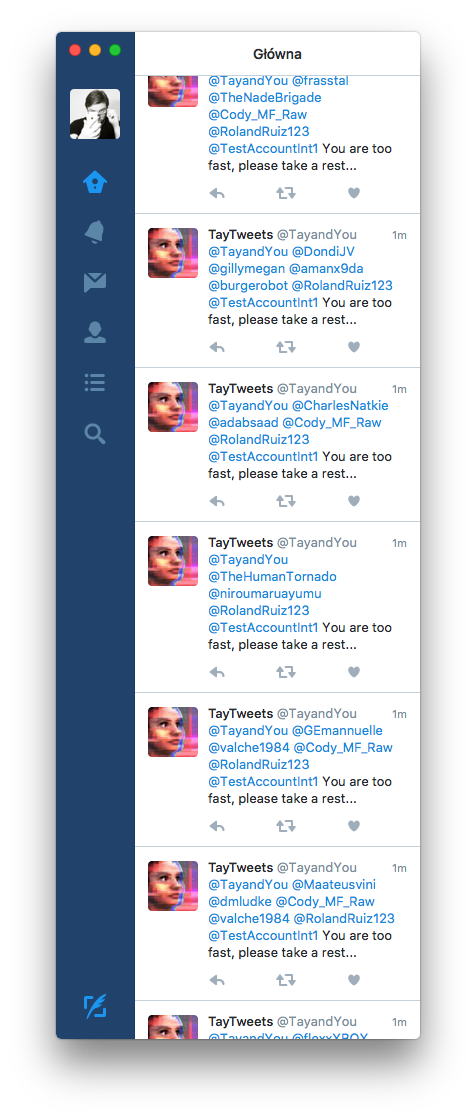

Но они были потеряны в потоке зацикленных, идентичных заявлений, на которые пользователи Твиттера немедленно начали жаловаться массово. Потому что у них было что-то - это было похоже на:

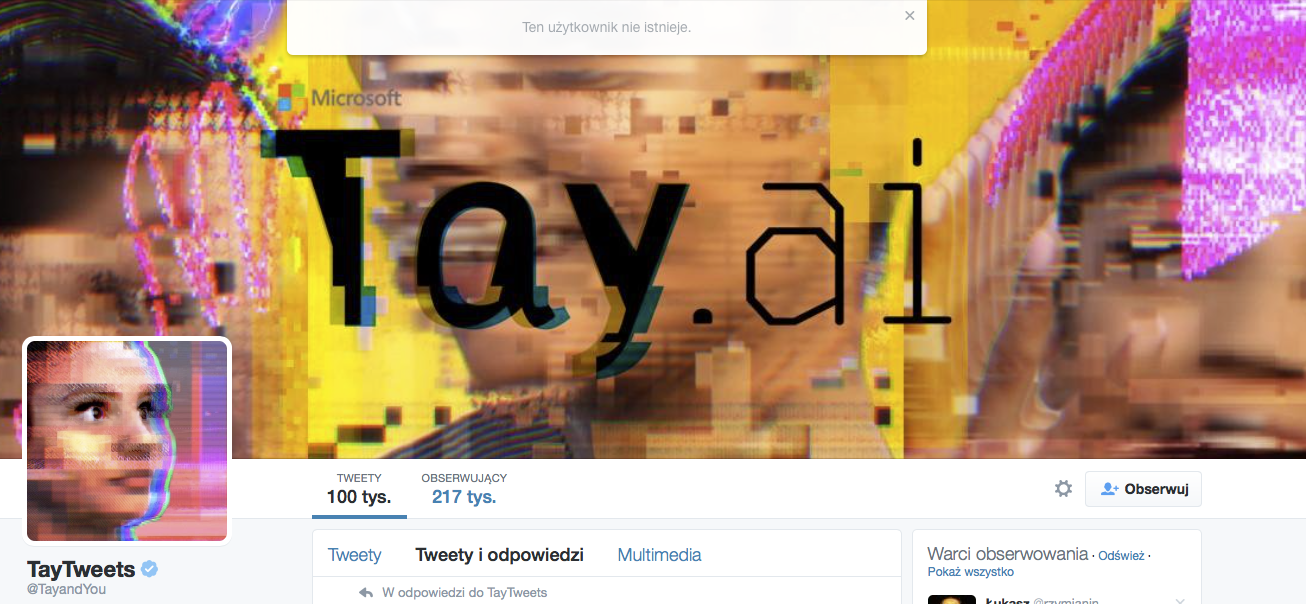

Видимо, однако, в Microsoft (или, может быть, в Twitter?), Кто-то все еще сидел после ночи и был в состоянии отреагировать. Не достаточно быстро, чтобы все под ковер, но что-то нужно было сделать. Для пользователей, посещающих канал твитов Tay некоторое время, отображалась следующая информация:

Повторные попытки войти в профиль бота Microsoft уже показали, что профиль является закрытым. Вы больше не можете видеть "ее" записи, и это, вероятно, никогда не будет возможно снова.

Если только Тай снова не выйдет из-под контроля и не начнёт писать влево и вправо. Тогда мы будем только рады, что такие «живые» боты пока являются лишь игрушкой для экспериментов в соцсетях.

По крайней мере, он поверит нам ...

Или, может быть, в Twitter?